Wie viel CO2 verursacht ein Produkt meines Unternehmens pro Stück? An welchen Stellschrauben kann ich drehen, um die Emissionen zu reduzieren? Diese Fragen beschäftigen immer mehr Firmen. Die Antworten zu finden, ist oft nicht leicht. Doch dabei hilft der MFCA-Demonstrator des Mittelstand-Digital Zentrums Klima.Neutral.Digital.

Entwickelt und parametrisiert hat das Tool Jürgen Seibold, Spezialist für intelligente, nachhaltige Produktion beim Klima.Neutral.Digital-Unterauftragnehmer Deutsche Institute für Textil- und Faserforschung (DITF). Mit dem Demonstrator zur Nachhaltigkeitsmodellierung und -bewertung können produzierende Unternehmen schnell und einfach den Carbon Footprint von Produkten (PCF) ermitteln. Dieser basiert auf der Methode des Material Flow Cost Accounting (MFCA), die man üblicherweise verwendet, um die Kosten von Produkten zu berechnen. Programmiert hat Seibold den Demonstrator in einem Standard-Programm für Lebenszyklus-Analysen. „Wir nutzen dafür die Software Umberto LCA+, mit der sich Produktionsprozesse modellieren und analysieren lassen“, erklärt er.

Software macht die Auswirkungen einzelner Prozessschritte sichtbar

Will man den CO2-Abdruck ermitteln, werden zunächst alle relevanten Prozessschritte erfasst – vom Materialeingang über die einzelnen Bearbeitungsstufen bis hin zur Auslieferung. Für jeden Schritt trägt man die benötigten Einsatzfaktoren wie Rohstoffe, Energie oder Betriebsmittel ein. Die Software greift dann auf hinterlegte Datenbanken zu und berechnet die damit verbundenen Emissionen für jeden Schritt der Verarbeitungskette. Dies stellt sie in einem Prozess-Schaubild dar und macht so große Auswirkungen auf einen Blick sichtbar. „So erhält man sehr schnell einen Überblick, welche Prozesse besonders CO2-intensiv sind und wo die größten Hebel für Einsparungen liegen“, erklärt Seibold.

Oft ergäben sich dabei Aha-Effekte, welcher Schritt als besonders CO2-intensiv heraussteche. An diesem setze man dann zuerst an, um den Fußabdruck zu minimieren. Zum Beispiel, indem man eine erste Qualitätssicherung in der Kette nach vorne verlagert, bevor die Produkte in einen energieintensiven Verarbeitungsprozess gehen.

Simulation berechnet Einsparpotenziale

Um Einsparpotenziale aufzudecken, lassen sich in dem Modell ganz einfach Änderungen simulieren: Wie wirkt es sich aus, wenn ich Materialien austausche, Prozesse verändere oder auf Ökostrom umstelle? Welche Maßnahmen bringen den größten Effekt? „Unser Ziel ist es, dass die Unternehmen eine Entscheidungsgrundlage bekommen, um die richtigen Stellschrauben in Richtung CO2-Reduktion zu drehen“, so Seibold. Da er mit demselben Demonstrator auch die Stückkosten berechnen und mit den eigenen Kalkulationen der Unternehmen vergleichen kann, erhält man sofort eine Abschätzung, wie valide die Daten des Modells sind, also wie nah an den tatsächlichen Prozesskosten bzw. dem Carbon Footprint.

Schnelle CO2-Berechnung für den Mittelstand

Oft haben gerade kleine und mittlere Unternehmen (KMU) nicht die Kapazitäten, um sich tiefgehend mit dem Thema Ökobilanzierung zu beschäftigen. Doch auch diese sind als Zulieferer zunehmend gefordert, den CO2-Fußabdruck ihres Produkts zu benennen oder Berichtspflichten zu erfüllen. „Mit unserem Demonstrator können auch KMU ganz niedrigschwellig einsteigen und wertvolle Erkenntnisse für mehr Klimaschutz im eigenen Betrieb gewinnen“, betont der Experte. Wie alle Unterstützungsangebote von Klima.Neutral.Digital ist dieses Angebot für Mittelständler kostenfrei.

Klassische KI-Modelle lernen einmal mit einem festen Datensatz und arbeiten dann unverändert – bis die Realität sich so weit gewandelt hat, dass ihre Vorhersagen ungenau werden. Beim Lifelong Learning hingegen wird die Künstliche Intelligenz mit neuen Daten permanent weitertrainiert und damit -verbessert.

„Wir entwickeln KI-Systeme, die kontinuierlich aus Datenströmen lernen“, erklärt Janek Bender, Wirtschaftsinformatiker beim FZI Forschungszentrum Informatik, einer der Partner des Mittelstand-Digital Zentrum Klima.Neutral.Digital. „So passen sie sich an Veränderungen an und treffen weiter zuverlässige Vorhersagen.“ Eine solche Lifelong Learning KI – oder auch Online Learning im Gegensatz um Offline Learning mit einem statischen Datensatz – kann gerade im dynamischen Umfeld produzierender kleiner und mittlerer Unternehmen (KMU) von Vorteil sein, wenn sich Prozesse, Materialien und Bedingungen ständig wandeln.

Kosten gesenkt – Termine besser planbar

In einem Projekt mit mehreren Unternehmen zeigte Bender, wie Lifelong Learning KI die Soll- und Liegezeiten in der Produktion um bis zu 50 Prozent genauer prognostiziert als gängige Methoden, also die Zeit für einen Prozessschritt in der Produktion und die Zeit, in der das Teil dazwischen lagert. Durch die präzisere Planung der Produktionsabläufe sinken die Kosten. Liefertermine lassen sich besser einhalten.

Einsetzbar für alle Arten von veränderlichen Datenströmen

Doch Lifelong Learning eignet sich nicht nur für Zeitreihen aus der Fertigung. Auch Sensordaten von Maschinen und Anlagen, Energieverbräuche oder Absatzzahlen lassen sich damit analysieren und Vorhersagemodelle kontinuierlich verbessern. „Überall, wo Datenströme anfallen, lässt sich dieser Ansatz im Prinzip anwenden“, betont Bender. Und hilft Mittelständlern dabei, das Potenzial ihrer Daten voll auszuschöpfen, besonders dann, wenn diese Daten sich recht häufig verändern. Concept-Drift-Detektoren können diese Veränderungen aufspüren. „Über Concept Drift Adaption kann man das Modell so anpassen, dass es auf den neuen Daten funktioniert“, so Bender. Denn das Ziel ist eine möglichst robuste KI.

KI-Trainer stehen zur Unterstützung bereit

Interessierte Unternehmen können sich an die KI-Trainer von Klima.Neutral.Digital wenden, um die Möglichkeiten von Lifelong Learning für ihre spezifischen Anwendungsfälle zu diskutieren. In einem Erstgespräch analysieren diese gemeinsam mit den Firmenvertretern die Ausgangssituation und skizzieren mögliche Lösungsansätze. So lässt sich schnell herausfinden, ob und wie das Unternehmen von der Technologie profitieren kann.

Wer Energieflüsse clever steuern will, muss wissen, was wann in welchem Umfang verbraucht wird und wann wie viel Strom zu welchen Preisen verfügbar sein wird. Prognosen sind hier ein zentrales Hilfsmittel. Sie ermöglichen es, den Energieeinsatz zu planen und zu optimieren.

Inhaltsverzeichnis

Zum einen geht es für kleine und mittlere Unternehmen darum, den eigenen Verbrauch vorherzusagen: Wie viel Strom wird in den nächsten Stunden oder Tagen benötigt? Welche Anlagen laufen wann? Welche Lasten sind beeinflussbar, welche nicht? Nur so lässt sich ermitteln, wie viel Flexibilität zur Verfügung steht. Diese ist Voraussetzung für ein intelligentes Energiemanagement. Auch die Wärme- und Kältebedarfe spielen hier mit hinein.

Andererseits sind auch Prognosen wichtig, wann Strom besonders günstig sein wird – anhand von Wettervorhersagen und Daten des Strommarkts. Denn die Strompreise an der Börse stehen am Vortag fest. Falls vorhanden, muss man zusätzlich die Erzeugung des eigenen PV-Stroms prognostizieren, um den Eigenverbrauch zu optimieren. Einige Dienstleister bieten hier bereits Services an, die anhand von Wetterdaten und Anlagenparametern die Produktion in den nächsten Stunden und Tagen vorhersagen. Über Lastmanagement lassen sich dann Verbrauch optimieren und Kosten reduzieren.

Algorithmen prognostizieren Verbrauch und lernen selbst dazu

Gerade Gebäude bieten durch ihre thermische Trägheit oft Spielräume für eine flexible Betriebsweise von Heizung und Kühlung. Hier kommt es darauf an, das Gebäudeverhalten richtig vorherzusagen: Wie entwickeln sich Temperatur und Energiebedarf, wenn ich die Heizung für eine gewisse Zeit etwas herunterregele oder die Kühlung später einschalte? Welche Abweichungen vom Sollwert sind akzeptabel, ohne dass es zu Komforteinbußen kommt? Ein halbes Grad Unterschied in der Raumtemperatur wird nicht wahrgenommen, kann aber bereits helfen, Energie einzusparen. Früher musste man für solche Vorhersagen mühsam Daten zusammentragen und Modelle erstellen. Heute übernehmen das zunehmend intelligente Algorithmen. So lässt sich der Energieverbrauch von Gebäuden oder Anlagen vorhersagen, ohne dass man jedes Detail manuell erfassen und modellieren muss.

Je mehr Daten, desto treffsicherer die Vorhersagen

Die Expertinnen und Experten von Klima.Neutral.Digital arbeiten auch mit Methoden des maschinellen Lernens, wenn sie kleine und mittlere Unternehmen unterstützen. Die Algorithmen analysieren Verbrauchsdaten der Vergangenheit, erkennen Muster und bilden so das Systemverhalten nach. Dabei lernen sie selbstständig, welche Einflussfaktoren relevant sind – von Wetter und Belegung bis hin zu Ferienzeiten. Je mehr Daten zur Verfügung stehen, desto treffsicherer werden die Modelle.

Auf Basis solcher Prognosen lassen sich Fahrpläne für eine optimierte Energienutzung erstellen. Weichen die tatsächlichen Verbräuche von der Vorhersage ab, passen lernende Algorithmen die Planung laufend an. So wird das System im Laufe der Zeit immer genauer und treffsicherer.

Dabei muss es gar nicht immer um einzelne Anlagen oder Gebäude gehen. Auch für einen ganzen Unternehmensstandort lässt sich anhand historischer Lastgänge ein Verbrauchsprofil erstellen und fortschreiben. So erkennt man typische Muster wie Tages- und Wochenzyklen und kann die Beschaffung und Erzeugung von Energie vorausschauend planen.

Inhaltsverzeichnis

Bauteile produzieren, ohne dafür spezielle Werkzeuge zu benötigen – das ermöglichen digitale Produktionsverfahren. Das Prinzip dahinter lässt sich vereinfacht formulieren: Datei rein, Produkt raus. Dieser Ansatz birgt enormes Potenzial für Unternehmen, ressourcenschonender und flexibler zu produzieren. Deshalb hat es sich das Mittelstand-Digital Zentrum Klima.Neutral.Digital zur Aufgabe gemacht, Firmen dabei zu unterstützen, digitale Produktionsverfahren einzuführen. Ob Digital Engineering, additive Fertigung, digitalisierte Prozessketten oder individualisierte Produkte: In allen Teilbereichen bringen die Klima-Coaches Expertise mit, die sie kleinen und mittleren Unternehmen bei einer kostenfreien Erstinformation zur Verfügung stellen.

Prozesse beginnen am Computer

Digitale Produktionsverfahren beginnen bei der Konstruktion und beim Design, also im Digital Engineering mit Computer Aided Design (CAD). „Es macht immer Sinn, im Produktdesign die Fertigung mitzudenken, um spezifisch die Vorteile von digitalen Produktionsverfahren zu nutzen“, erklärt Klima-Coach Tobias Vieten vom Klima.Neutral.Digital-Partner Hahn-Schickard Institut. Digitalisierte Prozessketten verknüpfen dann die CAD-Modelle mit speziellen Fertigungstechniken. Ergänzt werden sie beispielsweise durch Retrofit-Sensorik, die die Steuerung von Maschinen wesentlich verbessern kann.

Schicht für Schicht Ressourcen schonen

Die additive Fertigung, oft ungenau als 3D-Druck bezeichnet, ist ein solches digitales Produktionsverfahren. „Hier geht es darum, ein Bauteil herzustellen ohne geometriespezifische Werkzeuge, wie Spritzguss- oder Formwerkzeug“, sagt Vieten. Anders als bei subtraktiven Verfahren wird ein Bauteil Schicht für Schicht aus einem Halbzeug aufgebaut – ohne formgebende Werkzeuge. Dies spart Material und Ressourcen ein. Zudem lassen sich Bauteile dezentral fertigen, indem man die Daten überträgt, statt die Teile zu transportieren.

Stückzahl 1 wird rentabel

Individualisierte Produkte entstehen dank digitaler Produktion passgenau. Rentabel funktioniert dies meist nur mit digitalen Produktionsverfahren. Ein Beispiel wären Brillengestelle, die man übers Internet ordern und die Bügellänge oder andere Parameter selbst bestimmen kann. In der Medizintechnik sind patientenindividuelle Produkte dank ihrer flexiblen Anpassbarkeit auf den einzelnen Menschen längst Standard. Aber auch Ersatzteile für sehr alte Anlagen lassen sich so ressourcenschonend und wirtschaftlich herstellen, sehr teure Bauteile auf die Art reparieren.

Die Coaches des Mittelstand-Zentrums unterstützen KMU dabei, die Potenziale digitaler Produktionsverfahren zu erschließen. Sie zeigen auf, welche Technologien für welche Anwendungen geeignet sind und wie man sie gewinnbringend einsetzt. So ebnen sie den Weg in eine ressourcenschonende Zukunft der Fertigung.

Auch Interessant:

Inhaltsverzeichnis

Mit dem richtigen Einsatz von Sensoren an älteren Maschinen können kleine und mittlere Unternehmen (KMU) ihren Verbrauch an Energie und Material senken. So verbessern sie ihre Betriebsabläufe und kommen der Klimaneutralität einen Schritt näher. Sensorik ist eines der Schwerpunktthemen des Mittelstand-Digital Zentrums Klima.Neutral.Digital. Mit einer kostenfreien Erstinformation unterstützt Klima.Neutral.Digital Betriebe bei der Prozessoptimierung mit Retrofit-Sensorik.

Wie moderne Sensorik alte Maschinen effizienter macht

Klassische Sensoren bestehen vereinfacht gesprochen aus einem Bauteil, das einen physikalischen Effekt in ein elektrisches Signal umgewandelt. Als einer von fünf Partnern des Mittelstand-Digital Zentrums Klima.Neutral.Digital verfügt die Hahn-Schickard Gesellschaft für angewandte Forschung in Stuttgart über Expertise darin, Sensoren dort anzubringen, wo dies bisher kaum möglich war, also eine Sensorintegration in Maschinen oder Komponenten. „Wir messen direkt am Ort des Geschehens“, erklärt Dr. Karl-Peter Fritz, Institutsleiter des Hahn-Schickard-Instituts für Mikroaufbautechnik. Eine Möglichkeit: Bauteile einer Maschine selbst zu sensorisieren. Den Fräskopf einer Fräsmaschine nennt Fritz als Beispiel dafür: Um die Temperatur am Fräser zu messen, würde man klassisch mit berührungslosen Infrarotsensoren arbeiten. Eingespritztes Kühlmittel verhindert aber die Messung. „Man kann sagen: Ich mache den Fräser selbst zum Sensor, indem ich einen elektrischen Widerstand aufdrucke und messe, wie sich der Widerstand ändert“, so Fritz.

Dieses Vorgehen ermöglicht präzisere Messungen. Es verringert Quereffekte und Störungen oder vermeidet diese gänzlich. Mit seinen Innovationen gelingt es dem Forschungsteam, in beengten und aggressiven Umgebungen zu messen, in denen das bisher kaum möglich war – weil dort etwa hohe Temperaturen oder Drücke herrschen oder Medien wie Kühlmittel zirkulieren.

Sensorisierung hilft, Prozesse zu optimieren

Sind die Sensoren angebracht, ermöglichen deren Daten zunächst, den technischen Zustand einer Anlage oder Produktionsstätte zu erfassen und zu überwachen („Condition Monitoring“). Dazu zählen auch Material- und Energieverbrauch oder Umweltparameter. Die Daten im nächsten Schritt zu analysieren, hilft dabei, Prozesse besser zu verstehen. Fehler lassen sich schneller finden, Anlagen vorausschauend warten. Die Prozessoptimierung ermöglicht eine höhere Wirtschaftlichkeit des Maschineneinsatzes und damit eine verbesserte Energieeffizienz. Diese Effizienzsteigerung trägt um Umweltschutz bei und hilft KMU auf dem Weg zur Klimaneutralität.

Vorhandene Messgrößen analysieren, Spezial-Sensoren nachrüsten

Wenn sich ein KMU mit der Bitte um einen Effizienz-Check für seine Produktionsstätte an Klima.Neutral.Digital wendet, schaut sich das Team zunächst den Prozess an: Welche Messgrößen kämen für eine Prozessoptimierung infrage? Dies kann neben der Temperatur der Druck oder die Feuchte sein, Magnetfelder, Bewegungen, Neigungen, Vibrationen, Licht oder Strömungen. Welche innovativen Sensorsysteme zu diesen Messgrößen entwickelt hat, zeigt Hahn-Schickard auf dem Demonstrator „Rocket Man“.

Den Blick richten die Fachleute auch auf die vorhandenen Maschinendaten: Wie werden diese verwendet, gespeichert und strukturiert? Oft könnte man Maschinen oder Prozesse bereits verbessern, wenn man vorhandene Daten besser nutzt, speichert oder auswertet, sagt Fritz. Will das Unternehmen einen Schritt weitergehen, stellt sich die Frage, welche zusätzlichen Parameter dazu nötig sind und mit welchen Sensoren man diese misst.

Vier Stufen der Sensorintegration

Zur Retrofit-Sensorik alter Maschinen hat das Team in seinem Fachbuch „Digitaler Retrofit“ vier Stufen definiert. Deren einfachste, „Sustaining“, ist eine Huckepack-Lösung, bei der zusätzliche Sensoren von außen an eine Maschine angebracht werden. In der zweiten Stufe „Kooperativ“ zieht man aus vorhandenen Schnittstellen der Maschine die Informationen ab, um sie nach der Datenerfassung zu interpretieren.

In der dritten Stufe „Integrativ“ werden – wie am Beispiel des Fräskopfs beschrieben – einzelne Bauteile selbst sensorisiert. Und in der vierten und höchsten Stufe „Disruptiv“ greift man mit den gewonnenen und analysierten Sensordaten in die Maschinensteuerung ein, um diese zu verbessern. Für die beiden letzten Stufen reicht es nicht mehr aus, die Hilfe des Mittelstand-Digital Zentrums Klima.Neutral.Digital in Anspruch zu nehmen. Hier muss auch der Hersteller der Maschine mitziehen, da sonst die Gewährleistung für die Anlage erlöschen würde. Eingehender beschreibt Fritz die vier Stufen des digitalen Retrofit auch im Podcast von Klima.Neutral.Digital.

Wer profitiert von dem Assistenz-Angebot zur Sensorisierung?

Hilfestellung bietet Klima.Neutral.Digital im Bereich Sensorik allen Unternehmen und Handwerksbetrieben des verarbeitenden Gewerbes, einfacher gesagt allen Betrieben, in denen Maschinen laufen. Ein einfacher Demonstrator in Form eines Sensor-Koffers für Retrofit-Sensorik hilft beispielsweise dabei, den Stromverbrauch einer Maschine zu messen. Das Unterstützungsangebot an KMU ist kostenfrei, da Klima.Neutral.Digital vom Bundesministerium für Wirtschaft und Klimaschutz gefördert wird.

Inhaltsverzeichnis

In einer Zeit, in der der Klimawandel immer spürbarer wird und die Nachhaltigkeit eine immer wichtigere Rolle in der Unternehmensführung spielt, stehen auch kleine und mittlere Unternehmen (KMU) vor der Herausforderung, nachhaltige Lösungen zu finden, die sowohl ökologische als auch wirtschaftliche Vorteile bieten. Der Umstieg auf erneuerbare Energien spielt eine zentrale Rolle, um diese Anforderung zu erfüllen.

In diesem Text erfahren Sie, wie sich das Energiesystem ändert. Daraus ergeben sich die Optionen und Chancen Ihr Unternehmen nachhaltiger auszurichten. Außerdem beleuchten wir, was Sie beachten müssen und welche Aspekte Ihres Unternehmens dabei eine Rolle spielen. Wir diskutieren auch die Herausforderungen, die mit dem Umstieg auf erneuerbare Energien einhergehen, und welche Vorteile Ihr Unternehmen daraus ziehen kann.

Warum sollte mein Unternehmen sich mit erneuerbaren Energien beschäftigen?

Der Umstieg auf erneuerbare Energien bietet zahlreiche Vorteile für Ihr Unternehmen. Neben der Reduzierung von CO2-Emissionen können Sie Ihre Energiekosten langfristig senken und Ihre Abhängigkeit von fossilen Brennstoffen verringern. Darüber hinaus stärken Sie Ihr Image als nachhaltiges Unternehmen und positionieren sich als Vorreiter in Ihrer Branche.

Wie ändert sich das Energiesystem und was bedeutet der Umstieg auf erneuerbare Energien für die Energienutzung in meinem Unternehmen

Das Energiesystem der Zukunft erfordert eine Abkehr von fossilen Brennstoffen. Grundsätzlich findet eine Elektrifizierung des Energiessystems statt, mit Strom aus Windkraft- und Photovoltaikanlagen als primärer Energiequelle. Durch den Einsatz von Wind- und Solarkraftwerken als zentrale Säulen ergibt sich eine Abkehr von zentralen Kraftwerken hin zu einer vermehrt dezentralen Versorgung. Aufgrund der fluktierende Quellen Wind und Sonne bekommen zentrale und dezentrale Speicher eine große Bedeutung, ebenso die Flexibilisierung des Verbrauchs. Durch die gute Skalierbarkeit von Photovoltaik (PV) Anlagen, können sich Unternehmen lokale Erzeugungsstrukturen auf der Basis von PV Dachanlagen schaffen und eine gewisse Unabhängigkeit vom Strommarkt schaffen.

Im Zuge der Elektrifizierung des Energiesystems werden auch Wärme- und Kälte sowie die Mobilität zunehmend über Strom bereitgestellt werden. Dies ist sehr effizient möglich, da Strom physikalisch eine „gerichtete Energieform“ darstellt. Daher kann elektrische Energie ein Fahrzeug um den Faktor 4 effizienter fortbewegen und erzeugt um den Faktor 3-5 mehr Niedertemperaturwärme über Wärmepumpen als Kraftstoffe bzw. Brennstoffe.

Die genannten Zahlen machen deutlich – der Umweg vom Strom über E-Fuels und deren anschließende herkömmlich Nutzung ist sehr ineffizient. E-Fuels werden für einige Anwendungen unersetzbar sein, wie beispielsweise den Flugverkehr. Aufgrund der zu erwartenden Knappheit sollte die Elektrifizierung von Anwendungen die dies zulassen, der Verwendung von E-Fules vorgezogen werden. Ähnliches gilt für Wasserstoff, weshalb er auch als Champagner der Energiewende bezeichnet wird. Wo Wasserstoff nicht ersetzbar ist, etwa für die Erzeugung von Strom in der Dunkelflaute im Winter oder für die Stahlherstellung, muss er weiterhin eingesetzt werden. Er wird dadurch knapp und teuer sein.

Studien zeigen, dass ein ähnlich ambitionierter Hochlauf der weltweiten E-Fuels Projekte wie bei der Photovoltaik bis 2035 lediglich zu einer Deckung des heutigen deutschen Bedarfs an Kraft- bzw. Brennstoffen von 10% führen würden. Es ist also keine Frage der Technologieoffenheit, sondern eine Frage der realistischen Prognose und Anerkennung der physikalischen Randbedingungen, wenn man Wasserstoff und E-Fuels nur dort einsetzt, wo sie nicht ersetzt werden können. Die direkte Elektrifizierung von Prozessen und Abkehr von Brennstoffen, wo immer möglich, muss daher das Ziel sein.

Insgesamt bedeutet der Umstieg auf erneuerbare Energien für Ihr Unternehmen also eine Anpassung an die Veränderungen im Energiesystem und die Integration von neuen Technologien und Geschäftsmodellen. Es eröffnet jedoch auch Chancen für Kosteneinsparungen, Imageverbesserungen und eine nachhaltigere Geschäftstätigkeit. Eine gründliche Analyse der Möglichkeiten und Herausforderungen ist entscheidend, um die richtigen Schritte für Ihr Unternehmen zu identifizieren.

Welche Aspekte meines Unternehmens muss ich beachten, wenn ich auf erneuerbare Energieversorgung umsteigen will?

Am Anfang steht die Erfassung des Ist-Zustands: d.h. die bisher genutzten Energiequellen, die Jahresbedarfe für die genutzten Brennstoffe und des Strombezugs, sowie das Profil Ihres Strombezugs. Dann sind die benötigten Endenergien aufzustellen, d.h. Wärmebedarf und notwendige Temperatur für die verschiedenen Prozesse (Raumheizung, Warmwasserheizung, Trockungsprozesse, etc.), Kältebedarf und Temperaturniveaus, Strombezug für IT Infrastruktur, Beleuchtung, Maschinen, Druckluftbereitstellung etc. Schließlich werden die Energiewandler angeschaut, die bisher aus den Energiequellen die benötigten Endenergien bereitstellen bzw. Prozesse antreiben.

Zu beachten sind weiterhin der Energiebedarf für Mobilität, d.h. für Fahrzeugflotten, den Weg zum Arbeitsplatz, für Dienstreisen, den Transport von Ausgangsstoffen und gefertigten Produkten.

Schließlich ist die Analyse der Gebäudestruktur wichtig. Diese gibt Hinweis auf das Potential für Energieeinsparungen durch Sanierungsmaßnahmen, die Möglichkeit mit Photovoltaikanlagen auf Dach, Fassade oder überdachtem Parkplatz lokal Strom zu erzeugen.

Aus der Analyse des Ist-Zustands und den Bedarfen an Endenergie wird ein Konzept erstellt. Einerseits für Energieeinsparpotentiale, andererseits für die veränderte Bereitstellung von Endenergie, die effizienter und klimafreundlicher, d.h. mit weniger CO2-Wirkung erfolgt.

Insgesamt bedeutet der Umstieg auf erneuerbare Energien für Ihr Unternehmen also eine Anpassung an die Veränderungen im Energiesystem und die Integration von neuen Technologien und Geschäftsmodellen. Es eröffnet jedoch auch Chancen für Kosteneinsparungen, Imageverbesserungen und eine nachhaltigere Geschäftstätigkeit. Eine gründliche Analyse der Möglichkeiten und Herausforderungen ist entscheidend, um die richtigen Schritte für Ihr Unternehmen zu identifizieren.

Wie gehe ich konkret vor

Planung und Umsetzung: Entwickeln Sie einen detaillierten Umsetzungsplan für den Umstieg auf erneuerbare Energien, der die Auswahl der geeigneten Technologien, die Finanzierung, die Installation und den Betrieb umfasst. Arbeiten Sie dabei eng mit qualifizierten Fachleuten und Energieberatern zusammen, um sicherzustellen, dass alle Schritte ordnungsgemäß durchgeführt werden. Qualifizierte und bei der BAFA registriert Energieberater müssen Ihre Vorhaben begutachten und begleiten, um Fördermittel zu erhalten. Sie beraten auch zu den Fördermöglichkeiten, kennen die Kriterien für förderfähige Vorhaben und stellen die Anträge.

Schulung und Sensibilisierung: Stellen Sie sicher, dass Ihre Mitarbeiter über die neuen erneuerbaren Energiesysteme informiert sind und geschult werden, um diese effektiv zu nutzen und zu warten. Sensibilisieren Sie auch Kunden, Lieferanten und andere Stakeholder für Ihre Bemühungen um Nachhaltigkeit und erneuerbare Energien.

Monitoring und Optimierung: Implementieren Sie ein Monitoring- und Bewertungssystem, um die Leistung Ihrer erneuerbaren Energiesysteme kontinuierlich zu überwachen und zu optimieren. Identifizieren Sie potenzielle Verbesserungsmöglichkeiten und passen Sie Ihre Strategie entsprechend an, um langfristig die besten Ergebnisse zu erzielen.

Wie bekomme ich einen Überblick zur Vorgehensweise beim Umstieg auf erneuerbare Energien für mein Unternehmen und einen nachhaltigen Einstieg in den Veränderungsprozess?

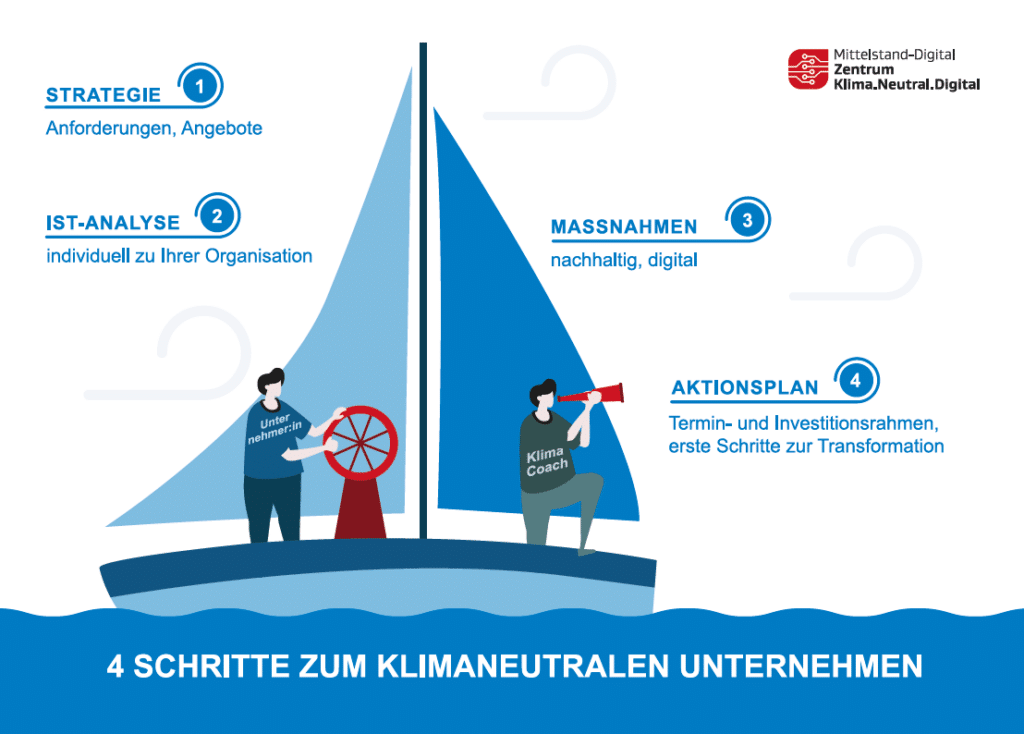

Nehmen Sie mit uns Kontakt auf. Ein Klima-Coach des Zentrums kommt in Ihr Unternehmen und informiert zur Vorgehensweise. Zusammen mit der Unternehmensleitung und den Beauftragten für Energieeffizienz und Nachhaltigkeit führen wir eine Ist-Analyse durch, schlagen Maßnahmen vor und entwickeln einen Aktionsplan. Die Institutspartner des Mittelstand-Digital Zentrum Klima.Neutral.Digital sind Experten im Bereich Energiesystem, Energiemanagement, nachhaltige Fertigungsprozesse und insbesondere auch dem Einsatz von Digitalisierung um Nachhaltigkeit in der Energienutzung und in den Fertigungsprozessen voranzutreiben.

Welche Vorteile habe ich als Unternehmen beim Umstieg auf erneuerbare Energien?

Durch den Umstieg auf erneuerbare Energien können Sie nicht nur Ihre Umweltauswirkungen reduzieren, sondern auch langfristige Kosteneinsparungen erzielen, Ihr Image als nachhaltiges Unternehmen stärken und Ihre Wettbewerbsfähigkeit verbessern. Darüber hinaus leisten Sie einen wichtigen Beitrag zum Klimaschutz und tragen zur Erreichung globaler Nachhaltigkeitsziele bei.

Wir hoffen, dass die Vorteile und Möglichkeiten des Umstiegs auf erneuerbare Energien für Ihr Unternehmen zu erkennen sind und Sie motivieren, diesen Schritt zu gehen.

Nehmen Sie Kontakt auf

Inhaltsverzeichnis

Das Thema IT-Sicherheit ist ein Querschnittsthema über alle digitalen Maßnahmen hinweg und die Risiken eines Cyberangriffs sollten auf jeden Fall sehr ernst genommen werden.

Die Digitalisierung an sich ist ein wesentliches Element und ein großer Hebel auf dem Weg zu mehr Nachhaltigkeit. Mit zunehmender Digitalisierung, Vernetzung von Systemen und digitaler Verarbeitung von Daten steigen aber auch die Möglichkeiten und damit die Risiken für Cyberangriffe. Dabei handelt es sich nicht immer um komplexe Angriffe auf ganze Produktionsanlagen. Ein unbedachter Klick auf den Anhang einer Mail mit Schadsoftware oder das Überweisen einer großen Geldsumme an vermeintliche Geschäftspartner ist oftmals schon ausreichend: Opfer eines Cyberangriffs zu werden, kann schwerwiegende Auswirkungen auf die Geschäftsprozesse eines Unternehmens haben. Im schlimmsten Fall können Unternehmen komplett lahmgelegt werden.

Während große Unternehmen umfangreiche Ressourcen für IT-Sicherheit zur Verfügung stellen können, ist das bei kleinen und mittleren Unternehmen (KMU) häufig nicht möglich. Obwohl KMU vielleicht nicht die gleichen hohen potenziellen Gewinne für Cyberkriminelle bieten wie größere Unternehmen, sind sie aufgrund des oftmals geringeren Aufwands für Sicherheitsmaßnahmen ein besonders attraktives Ziel für Cyberangriffe. Daher ist die Bedrohung durch Cyberkriminalität für KMU nicht weniger ernst zu nehmen.

IT-Sicherheits-Bedrohungen für KMU: Was kann passieren?

Laut Bitkom sehen 6 von 10 Unternehmen eine große Bedrohung in analogen und digitalen Angriffen und die Täter kommen öfter aus der organisierten Kriminalität.

- Phishing: Betrügerische E-Mails verleiten Mitarbeitende dazu, sensible Informationen preiszugeben. Darüber hinaus können diese E-Mails jedoch auch gefährliche Software wie Trojaner enthalten.

- Schwachstellen in Software: Veraltete Software oder fehlende Sicherheitsupdates können Einfallstore für Cyberangriffe sein.

- Kompromittierte Zugangsdaten: Gestohlene oder leicht erratbare Zugangsdaten erleichtern Cyberkriminellen den Zugriff auf Unternehmenssysteme.

IT-Sicherheitstipp Nr. 1: Zur Sensibilisierung stellt das Bundesamt für Sicherheit in der Informationstechnik (BSI) anhand von Hilfestellungen und Videos wichtiges Grundlagenwissen zur Verfügung.

Welche Unterstützung für IT-Sicherheit bietet Mittelstand-Digital?

Das Mittelstand-Digital-Netzwerk bietet kleinen und mittleren Unternehmen, Handwerksbetrieben und Start-ups eine Vielzahl kostenfreier Unterstützungsangebote in Bezug auf Cybersicherheit.

Die Transferstelle Cybersicherheit im Mittelstand unterstützt bei Prävention, Detektion und Reaktion auf Cyberangriffe: über Informations- und Qualifikationsformate, zahlreiche Veranstaltungen bundesweit, eine Detektions- und Reaktionsplattform für Cyberangriffe sowie ein breites Netzwerk an Partnern. Ziel ist, das Cybersicherheitsniveau im Mittelstand zu erhöhen und Unternehmen widerstandsfähiger gegenüber Cyberbedrohungen zu machen.

Die AG IT-Sicherheit spielt in diesem Kontext ebenfalls eine wichtige Rolle. Sie dient als Bindeglied zwischen der Transferstelle Cybersicherheit und den Mittelstand-Digital-Zentren in ganz Deutschland. Die Zusammenarbeit erhöht die Reichweite und Effektivität der Cybersicherheitsmaßnahmen und stellt sicher, dass die Unterstützung dort ankommt, wo sie am meisten benötigt wird. So können Unternehmen beispielsweise durch die Unterstützung von ISMS-Coaches Lösungsempfehlungen für ein geeignetes Informationssicherheitsmanagementsystem (ISMS) erhalten. Die ISMS-Coaches bieten kleinen und mittelständischen Unternehmen eine grundlegende Unterstützung bei der Einführung eines ISMS. Weiterhin stehen umfangreiche Informationsmaterialien zum Thema Cybersicherheit auf der Webseite der AG IT-Sicherheit zur Verfügung.

Als Partner im Mittelstand-Digital Zentrum Klima.Neutral.Digital denkt das FZI Forschungszentrum Informatik das Thema Cybersicherheit bei seinen Unterstützungsangeboten immer gleich mit und bringt seine Expertise im Rahmen von Veranstaltungen, Demonstratoren sowie direkt bei der Erstellung von Aktionsplänen auf dem Weg zur Klimaneutralität ein. Das FZI ist außerdem Fachpartner in der Transferstelle Cybersicherheit und in der Leitung der AG IT-Sicherheit.

IT-Sicherheitstipp Nr. 2:

Kennen Sie schon unsere Podcast-Reihe? Im Klima.Neutral.Digital Podcast IT-Sicherheit steht Dr. Frauke Goll Rede und Antwort zum Thema. Hier erwarten Sie viele weitere Tipps, denn Dr. Frauke Goll gibt zu Bedenken: „Menschen machen Fehler. Deswegen ist die wohl wichtigste Präventiv-Maßnahme die Schulung der Führungskräfte und der Mitarbeitenden. IT-Sicherheit ist wirklich Chefsache.“

Fazit

Das Thema IT-Sicherheit sollte auch bei KMU einen zentralen Stellenwert einnehmen: durch eine ganzheitliche Betrachtung von Cybersicherheit, die Einbeziehung von Mitarbeitenden und Führungskräften sowie die Zusammenarbeit mit Expert*innen. Nutzen Sie dabei auch die vielfältigen kostenfreien Angebote aus Mittelstand-Digital, um die Cybersicherheit in Ihrem Unternehmen zu stärken.

Kontakt

Sie möchten als KMU Ihre IT-Sicherheit stäken und mit Klima.Neutral.Digital zusammenarbeiten? Dann füllen Sie bitte unser Kontaktformular auf unserer Klima-Coach-Seite aus, damit wir uns mit Ihnen in Verbindung setzen können!